Cómo Funciona un Procesador o CPU

En el corazón de cada ordenador, se encuentra un componente crucial que orquestra cada tarea, cada cálculo y cada interacción: el procesador. Este pequeño chip, es el cerebro digital que da vida a nuestras máquinas, permitiéndonos navegar por internet, editar fotos, jugar videojuegos y realizar innumerables actividades que damos por sentadas en la era digital.

Imaginemos un ordenador como una orquesta sinfónica. El procesador sería el director de orquesta, interpretando la partitura del software y coordinando a cada instrumento, que en este caso serían los demás componentes del ordenador como la memoria RAM, el disco duro y la tarjeta gráfica. Sin un director preciso y eficiente, la orquesta sería un caos, incapaz de producir una melodía coherente. Del mismo modo, sin un procesador, un ordenador sería una colección inerte de componentes, incapaz de realizar ninguna función.

La evolución de los procesadores ha sido vertiginosa, impulsando el avance tecnológico a un ritmo sin precedentes. Desde los primeros microprocesadores de la década de 1970 hasta los complejos procesadores multinúcleo de hoy en día, la capacidad de procesamiento se ha multiplicado exponencialmente, permitiendo la creación de dispositivos cada vez más potentes y versátiles. Comprender cómo funciona un procesador es fundamental para entender el funcionamiento de los ordenadores y para apreciar la complejidad y la ingeniosidad que se esconde tras estos chips que han revolucionado nuestra forma de vivir, trabajar y comunicarnos.

Anatomía de un Procesador: Un Vistazo al Interior

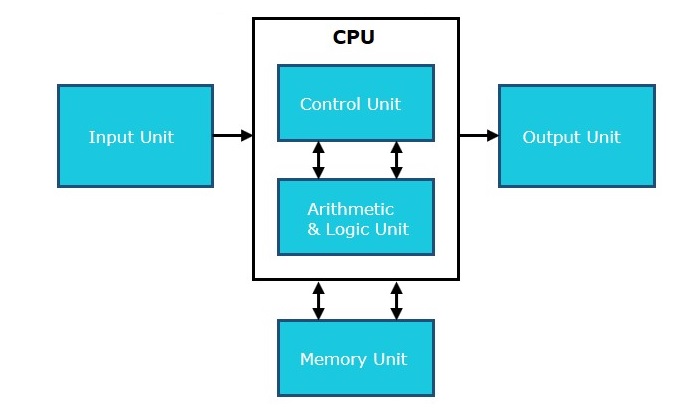

Para entender cómo funciona un procesador, es fundamental conocer sus componentes principales. Imaginemos el procesador como una pequeña ciudad, donde cada edificio tiene una función específica. Estos son algunos de los «edificios» más importantes:

Unidad de Control (CU): El «Cerebro» del Procesador

La Unidad de Control (CU) es el director de orquesta de nuestro procesador. Es la responsable de controlar el flujo de datos e instrucciones, decidiendo qué operación se debe realizar en cada momento y coordinando la actividad de los demás componentes. La CU se encarga de:

- Leer las instrucciones del programa: La CU lee las instrucciones una por una desde la memoria.

- Decodificar las instrucciones: Interpreta el significado de cada instrucción y determina qué operación se debe realizar.

- Controlar la ejecución de las instrucciones: Envía las señales necesarias a los demás componentes del procesador para que ejecuten la operación.

- Gestionar el flujo de datos: Controla la transferencia de datos entre los registros, la memoria caché y la memoria RAM.

Podríamos decir que la CU es el «cerebro» del procesador, el que toma las decisiones y dirige el tráfico de información. Su funcionamiento es esencial para el correcto funcionamiento del procesador.

Unidad Aritmético-Lógica (ALU): La «Calculadora» del Procesador

La Unidad Aritmético-Lógica (ALU) es la encargada de realizar las operaciones matemáticas y lógicas. Es como la «calculadora» del procesador, capaz de:

- Operaciones aritméticas: Suma, resta, multiplicación, división, etc.

- Operaciones lógicas: AND, OR, XOR, NOT, etc.

- Operaciones de desplazamiento de bits: Desplazar los bits de un dato a la izquierda o a la derecha.

- Comparaciones: Comparar dos valores para determinar si son iguales, mayores o menores.

La ALU es esencial para la ejecución de cualquier programa, ya que la mayoría de las instrucciones requieren algún tipo de cálculo o comparación. La velocidad y la eficiencia de la ALU son factores clave en el rendimiento del procesador.

Registros: Pequeñas Unidades de Memoria Ultrarrápidas

Los registros son pequeñas unidades de memoria ultrarrápidas que se encuentran dentro del procesador. Actúan como una especie de «bloc de notas» temporal, donde se almacenan datos e instrucciones que se están utilizando en ese momento. Características de los registros:

- Velocidad: Son mucho más rápidos que la memoria caché y la memoria RAM.

- Capacidad: Tienen una capacidad muy limitada, ya que solo almacenan datos e instrucciones que se están utilizando en ese momento.

- Tipos: Existen diferentes tipos de registros, cada uno con una función específica (registros de datos, registros de direcciones, registros de instrucciones, etc.).

Los registros son cruciales para la velocidad del procesador, ya que permiten acceder a la información de forma mucho más rápida que si tuviera que buscarla en la memoria RAM. La cantidad y el tipo de registros disponibles pueden influir en el rendimiento del procesador.

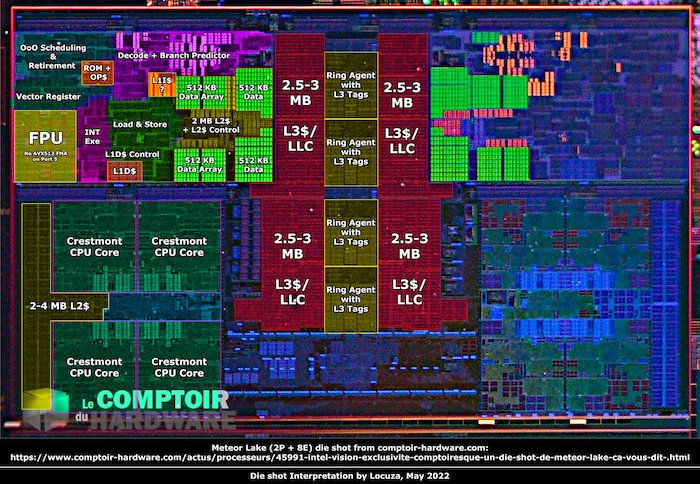

Memoria Caché (L1, L2, L3): Memorias Intermedias

La memoria caché es una memoria intermedia que se encuentra entre el procesador y la memoria RAM. Su función es almacenar las instrucciones y datos que se utilizan con más frecuencia, para que el procesador pueda acceder a ellos de forma más rápida. Características de la memoria caché:

- Niveles: Existen diferentes niveles de caché (L1, L2, L3), cada uno con una velocidad y capacidad diferentes.

- Velocidad: La caché L1 es la más rápida, seguida de la L2 y la L3.

- Capacidad: La caché L1 tiene la menor capacidad, seguida de la L2 y la L3.

- Funcionamiento: Cuando el procesador necesita acceder a un dato o instrucción, primero busca en la caché L1. Si no lo encuentra, busca en la L2, y así sucesivamente. Si no lo encuentra en ningún nivel de caché, entonces accede a la memoria RAM.

La memoria caché es un componente clave para el rendimiento del procesador, ya que reduce el tiempo que tarda en acceder a la información. Cuanto mayor sea la capacidad y la velocidad de la caché, mejor será el rendimiento del procesador.

Buses de Datos y Direcciones: Las «Autopistas» del Procesador

Los buses de datos y direcciones son las «autopistas» del procesador, las vías de comunicación que permiten la transferencia de información entre los diferentes componentes. Características de los buses:

- Bus de datos: Se utiliza para transportar los datos entre los diferentes componentes del procesador y la memoria.

- Bus de direcciones: Se utiliza para indicar la ubicación de los datos en la memoria.

- Ancho del bus: El ancho del bus determina la cantidad de datos que se pueden transferir simultáneamente. Cuanto mayor sea el ancho del bus, mayor será la velocidad de transferencia de datos.

- Frecuencia del bus: La frecuencia del bus determina la velocidad a la que se transfieren los datos. Cuanto mayor sea la frecuencia del bus, mayor será la velocidad de transferencia de datos.

La velocidad y el ancho de los buses influyen en el rendimiento del procesador. Unos buses rápidos y anchos permiten una transferencia de datos más rápida, lo que mejora el rendimiento general del sistema.

Conjuntos de Instrucciones: El «Lenguaje» del Procesador

Los conjuntos de instrucciones son el «lenguaje» que entiende el procesador. Cada procesador tiene su propio conjunto de instrucciones, que define las operaciones que puede realizar. Características de los conjuntos de instrucciones:

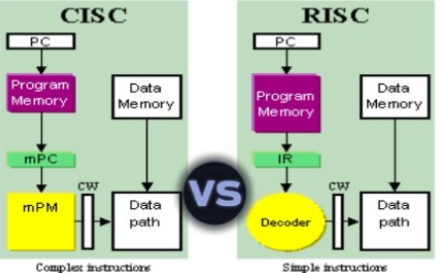

- Arquitecturas: Existen diferentes arquitecturas de procesadores, como CISC (Complex Instruction Set Computing) y RISC (Reduced Instruction Set Computing), que se diferencian en la complejidad y el número de instrucciones que soportan.

- CISC: Los procesadores CISC tienen un conjunto de instrucciones más complejo y amplio, lo que permite realizar operaciones más complejas con una sola instrucción. Sin embargo, esto puede hacer que la decodificación de las instrucciones sea más lenta.

- RISC: Los procesadores RISC tienen un conjunto de instrucciones más reducido y simple, lo que facilita la decodificación de las instrucciones y permite una ejecución más rápida. Sin embargo, las operaciones más complejas pueden requerir varias instrucciones.

- Importancia: El conjunto de instrucciones determina la compatibilidad del procesador con el software. Un programa compilado para una arquitectura específica solo funcionará en procesadores que soporten ese conjunto de instrucciones.

Conocer estos componentes nos da una idea general de cómo funciona el procesador por dentro. En las siguientes secciones, profundizaremos en el ciclo de instrucciones y en otros conceptos clave para comprender el funcionamiento de este complejo y fascinante componente.

El Ciclo de Instrucciones: El Latido del Procesador

El procesador funciona siguiendo un ciclo continuo de cuatro etapas, conocido como el ciclo de instrucción. Este ciclo es como el latido del corazón del procesador, repitiéndose miles de millones de veces por segundo para ejecutar las instrucciones que componen un programa. Cada etapa del ciclo juega un papel crucial en la ejecución correcta y eficiente de las instrucciones. A continuación, detallamos cada una de estas etapas:

Búsqueda (Fetch): Encontrando las Órdenes

La primera etapa del ciclo de instrucción es la búsqueda (fetch). En esta etapa, el procesador busca la siguiente instrucción a ejecutar en la memoria principal (RAM). Para ello, utiliza el Contador de Programa (PC), un registro especial que almacena la dirección de memoria de la próxima instrucción. El PC actúa como un puntero, indicando al procesador dónde debe buscar la siguiente instrucción. Una vez localizada la instrucción en la memoria, se copia al Registro de Instrucciones (IR), otro registro especial dentro del procesador.

El Contador de Programa (PC) se incrementa automáticamente después de cada búsqueda, de modo que apunta a la siguiente instrucción en la secuencia. Sin embargo, algunas instrucciones pueden modificar el valor del PC para realizar saltos o bifurcaciones en el programa. Esto permite al procesador ejecutar diferentes secciones del código en función de las condiciones del programa.

Decodificación (Decode): Interpretando el Lenguaje del Ordenador

Una vez que la instrucción se encuentra en el Registro de Instrucciones (IR), la siguiente etapa es la decodificación (decode). En esta etapa, el procesador interpreta la instrucción, determinando qué operación se debe realizar y qué datos se necesitan para realizarla. La instrucción se divide en dos partes principales:

- Opcode (Código de Operación): Indica la operación a realizar (suma, resta, multiplicación, salto, etc.).

- Operandos: Especifican los datos sobre los que se va a operar (registros, direcciones de memoria, valores inmediatos, etc.).

El Decodificador de Instrucciones es el componente encargado de interpretar el opcode y los operandos. Este componente traduce la instrucción a un conjunto de señales de control que se enviarán a los demás componentes del procesador para ejecutar la operación. El decodificador también se encarga de obtener los datos necesarios de los registros o la memoria, preparándolos para la siguiente etapa.

Ejecución (Execute): Poniendo Manos a la Obra

La tercera etapa del ciclo de instrucción es la ejecución (execute). En esta etapa, la Unidad Aritmético-Lógica (ALU) realiza la operación especificada por la instrucción. La ALU recibe los datos de los operandos, realiza la operación y almacena el resultado en un registro de destino.

La ALU puede realizar una amplia variedad de operaciones, incluyendo:

- Operaciones aritméticas: Suma, resta, multiplicación, división, etc.

- Operaciones lógicas: AND, OR, XOR, NOT, etc.

- Operaciones de desplazamiento de bits: Desplazar los bits de un dato a la izquierda o a la derecha.

- Comparaciones: Comparar dos valores para determinar si son iguales, mayores o menores.

Para las operaciones con números decimales, el procesador utiliza la Unidad de Coma Flotante (FPU), un componente especializado en el manejo de este tipo de datos. La FPU permite realizar cálculos con mayor precisión y eficiencia para aplicaciones que requieren un alto grado de precisión numérica, como simulaciones científicas, modelado 3D y procesamiento de imágenes.

Almacenamiento (Store): Guardando los Resultados

La última etapa del ciclo de instrucción es el almacenamiento (store). En esta etapa, el resultado de la operación se guarda en la memoria o en un registro, según lo especificado por la instrucción. El resultado puede almacenarse en:

- Registros: Si el resultado se va a utilizar en las siguientes instrucciones, se puede almacenar en un registro para un acceso más rápido.

- Memoria Caché: Si el resultado se va a utilizar próximamente, se puede almacenar en la memoria caché para un acceso más rápido que la memoria RAM.

- Memoria RAM: Si el resultado se va a utilizar más adelante o si no hay espacio disponible en los registros o la caché, se almacena en la memoria RAM.

Una vez que el resultado se ha almacenado, el ciclo de instrucción se repite, comenzando de nuevo con la etapa de búsqueda. Este ciclo continuo permite al procesador ejecutar miles de millones de instrucciones por segundo, dando vida a los programas y aplicaciones que utilizamos a diario.

Comprender el ciclo de instrucción es fundamental para entender cómo funciona un procesador. Cada etapa del ciclo juega un papel crucial en la ejecución correcta y eficiente de las instrucciones, y la velocidad a la que se completa este ciclo determina la velocidad de procesamiento del procesador. En las siguientes secciones, profundizaremos en otros aspectos del funcionamiento del procesador, como la arquitectura, la memoria caché y la gestión de la energía.

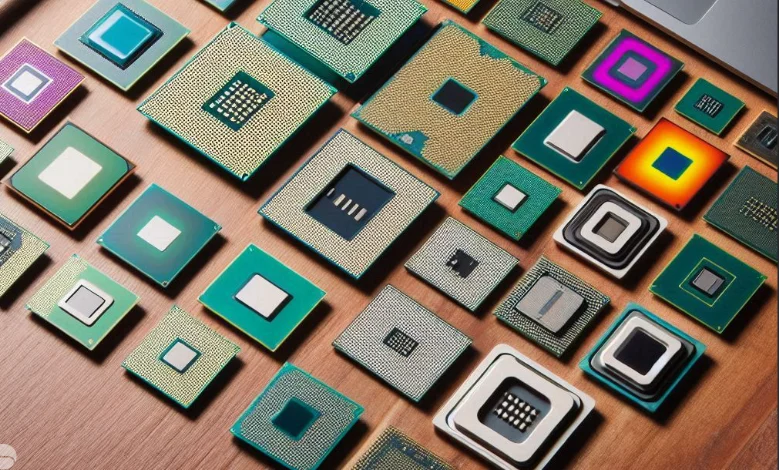

De los Transistores a los Núcleos: Evolución y Complejidad

La evolución de los procesadores ha sido una historia de constante innovación y miniaturización. Desde los primeros procesadores con unos pocos miles de transistores hasta los actuales con miles de millones, la capacidad de procesamiento ha aumentado exponencialmente. Esta increíble evolución ha sido impulsada en gran medida por la Ley de Moore, una observación que predijo que el número de transistores en un circuito integrado se duplicaría aproximadamente cada dos años.

La Ley de Moore ha sido un motor fundamental para el desarrollo de procesadores cada vez más potentes y complejos. La miniaturización de los transistores ha permitido integrar más componentes en un mismo chip, aumentando la capacidad de procesamiento y reduciendo el consumo de energía. Sin embargo, la Ley de Moore se enfrenta a sus propios límites, y en la actualidad existen desafíos importantes para seguir aumentando la densidad de transistores.

Limitaciones de la Ley de Moore: Los Desafíos Actuales

A medida que los transistores se hacen más pequeños, se acercan a los límites físicos de la miniaturización. Fabricar transistores a escalas nanométricas presenta desafíos técnicos y económicos cada vez mayores. Algunos de los desafíos más importantes son:

- Efectos cuánticos: A escalas nanométricas, los efectos cuánticos se vuelven más pronunciados, dificultando el control del comportamiento de los electrones.

- Disipación de calor: La concentración de miles de millones de transistores en un espacio reducido genera una gran cantidad de calor, lo que requiere sistemas de refrigeración más sofisticados.

- Coste de fabricación: El coste de fabricación de chips con transistores cada vez más pequeños aumenta exponencialmente, lo que limita la viabilidad económica de la miniaturización continua.

Estos desafíos han llevado a la búsqueda de nuevas estrategias para mejorar el rendimiento de los procesadores, más allá de la simple miniaturización de los transistores.

Estrategias para Mejorar el Rendimiento

Ante las limitaciones de la Ley de Moore, la industria ha desarrollado diferentes estrategias para seguir mejorando el rendimiento de los procesadores. Algunas de estas estrategias son:

- Aumento de la frecuencia de reloj: Aumentar la frecuencia de reloj del procesador permite ejecutar más instrucciones por segundo. Sin embargo, esto también aumenta el consumo de energía y la generación de calor.

- Reducción del tamaño de los transistores: Seguir reduciendo el tamaño de los transistores, aunque sea a un ritmo más lento, permite integrar más componentes en un mismo chip y mejorar la eficiencia energética.

- Nuevas arquitecturas: El desarrollo de nuevas arquitecturas de procesadores, como las arquitecturas multinúcleo, permite mejorar el rendimiento sin necesidad de aumentar la frecuencia de reloj o reducir el tamaño de los transistores.

Introducción al Concepto de Multi-núcleo

Una de las estrategias más importantes para mejorar el rendimiento de los procesadores ha sido la introducción de la arquitectura multinúcleo. Un procesador multinúcleo es un procesador que contiene varios núcleos de procesamiento independientes en un mismo chip. Cada núcleo puede ejecutar instrucciones de forma simultánea, lo que permite procesar información de forma más rápida y eficiente.

La arquitectura multinúcleo ha revolucionado la forma en que se diseñan y utilizan los procesadores. Los procesadores multinúcleo son capaces de manejar múltiples tareas de forma simultánea, lo que mejora el rendimiento en aplicaciones que requieren un alto grado de paralelismo, como la edición de vídeo, el renderizado 3D y los juegos.

La evolución de los procesadores ha sido un proceso continuo de innovación y adaptación. La Ley de Moore ha sido un motor fundamental para esta evolución, pero en la actualidad se enfrenta a importantes limitaciones. La industria ha desarrollado nuevas estrategias para seguir mejorando el rendimiento de los procesadores, como la arquitectura multinúcleo, que ha revolucionado la forma en que se procesa la información. El futuro de los procesadores se presenta emocionante, con nuevas tecnologías y arquitecturas que prometen seguir impulsando el avance tecnológico.

Más Allá de lo Básico: Conceptos Avanzados

Para aquellos que desean profundizar en el funcionamiento de los procesadores, existen una serie de conceptos avanzados que permiten comprender mejor la complejidad y la sofisticación de estos componentes. A continuación, exploramos algunos de estos conceptos:

Arquitectura CISC vs. RISC: Dos Enfoques Diferentes

Las arquitecturas CISC (Complex Instruction Set Computing) y RISC (Reduced Instruction Set Computing) representan dos enfoques diferentes para el diseño de procesadores. Las principales diferencias entre ambas arquitecturas son:

- CISC (Conjunto de Instrucciones Complejo):

- Gran cantidad de instrucciones complejas y especializadas.

- Las instrucciones pueden realizar varias operaciones en un solo ciclo de reloj.

- Mayor complejidad en el diseño del procesador y la decodificación de instrucciones.

- Ejemplos: Intel x86, IBM System/360.

- RISC (Conjunto de Instrucciones Reducido):

- Conjunto de instrucciones reducido y simple.

- Las instrucciones suelen realizar una sola operación en un ciclo de reloj.

- Menor complejidad en el diseño del procesador y la decodificación de instrucciones.

- Ejemplos: ARM, MIPS, PowerPC.

La elección entre una arquitectura CISC o RISC depende de las necesidades de la aplicación. Los procesadores CISC suelen ser más eficientes en la ejecución de código complejo, mientras que los procesadores RISC son más eficientes en la ejecución de código simple y repetitivo.

Pipeline: Ejecución Simultánea de Instrucciones

El pipeline es una técnica que permite al procesador ejecutar varias instrucciones de forma simultánea. El pipeline divide el ciclo de instrucción en varias etapas, y cada etapa se ejecuta en paralelo para diferentes instrucciones. De esta forma, mientras una instrucción se encuentra en la etapa de ejecución, otra instrucción puede estar en la etapa de decodificación, y otra en la etapa de búsqueda.

El pipeline mejora significativamente el rendimiento del procesador, ya que permite ejecutar más instrucciones en un mismo periodo de tiempo. Sin embargo, el pipeline también introduce cierta complejidad en el diseño del procesador, ya que es necesario gestionar las dependencias entre las instrucciones y evitar conflictos en el acceso a los recursos.

Overclocking: Aumentando la Velocidad del Procesador

El overclocking es una técnica que consiste en aumentar la frecuencia de reloj del procesador por encima de las especificaciones del fabricante. Esto permite aumentar el rendimiento del procesador, pero también aumenta el consumo de energía y la generación de calor.

El overclocking puede ser una opción para los usuarios que buscan un mayor rendimiento, pero es importante tener en cuenta los riesgos. Un overclocking excesivo puede dañar el procesador o reducir su vida útil. Es importante monitorizar la temperatura del procesador y asegurarse de que el sistema de refrigeración es adecuado.

Hyper-threading: Simulando la Presencia de Más Núcleos

El hyper-threading es una tecnología que permite a un único núcleo físico del procesador simular la presencia de dos núcleos lógicos. Esto permite al sistema operativo asignar tareas a los núcleos lógicos como si fueran núcleos físicos independientes, lo que puede mejorar el rendimiento en aplicaciones que pueden aprovechar el paralelismo.

El hyper-threading no es lo mismo que tener dos núcleos físicos, pero puede ofrecer una mejora de rendimiento significativa en ciertas aplicaciones. La eficacia del hyper-threading depende de la aplicación y del sistema operativo.

TDP (Thermal Design Power): El Consumo de Energía del Procesador

El TDP (Thermal Design Power) es una medida del consumo de energía del procesador. El TDP se expresa en vatios (W) e indica la cantidad de calor que el procesador genera en condiciones de máxima carga. El TDP es un factor importante a tener en cuenta a la hora de elegir un procesador, ya que determina la cantidad de calor que el sistema de refrigeración debe disipar.

Un TDP más alto indica un mayor consumo de energía y una mayor generación de calor. Los procesadores con un TDP alto suelen requerir sistemas de refrigeración más robustos. Es importante elegir un procesador con un TDP adecuado para el sistema de refrigeración del ordenador.

Estos son solo algunos de los conceptos avanzados relacionados con el funcionamiento de los procesadores. Profundizar en estos conceptos permite comprender mejor la complejidad y la sofisticación de estos componentes, que son el corazón de la informática moderna.