Qué es una CPU o procesador

¿Alguna vez te has preguntado qué hace que tu ordenador funcione? ¿Qué le permite ejecutar programas, navegar por internet o editar vídeos? La respuesta está en un pequeño pero potentísimo componente: la CPU o Unidad Central de Procesamiento. En este artículo, desentrañaremos los misterios de este componente esencial, explorando su funcionamiento, su evolución y su impacto en la tecnología moderna. Prepárate para un viaje al interior del cerebro digital que impulsa nuestros dispositivos.

La CPU es el componente fundamental de cualquier ordenador. Es la encargada de ejecutar las instrucciones de los programas, realizando cálculos, controlando periféricos y gestionando el flujo de datos. Imagina un director de orquesta que coordina a todos los músicos para crear una sinfonía; la CPU hace lo mismo con los diferentes componentes del ordenador, garantizando un funcionamiento fluido y eficiente.

Su importancia radica en que sin ella, nuestros ordenadores serían simples cajas inertes. La CPU es la que da vida al hardware, permitiendo que interactúemos con el software y realicemos tareas que van desde las más simples hasta las más complejas. Desde escribir un correo electrónico hasta diseñar modelos 3D, la CPU está detrás de todo.

A lo largo de este artículo, exploraremos en profundidad la arquitectura de la CPU, sus diferentes componentes y cómo interactúan entre sí. Desgranaremos conceptos como núcleos, hilos, frecuencia de reloj y caché, para que puedas entender qué hace que una CPU sea más potente que otra. Además, analizaremos la evolución de las CPUs a lo largo de la historia, desde los primeros modelos hasta las sofisticadas unidades de procesamiento actuales.

Historia y Evolución de la CPU

Para comprender el poderío de las CPUs modernas, es crucial echar un vistazo a su fascinante historia. Desde sus humildes comienzos hasta las complejas maravillas de ingeniería actuales, la evolución de la CPU es un testimonio del ingenio humano y su incesante búsqueda de la innovación tecnológica.

Primeros conceptos de unidades de procesamiento

Mucho antes de la llegada de los microchips de silicio, la idea de una unidad de procesamiento ya rondaba las mentes de los pioneros de la computación. La Máquina Analítica de Charles Babbage, concebida en el siglo XIX, se considera la precursora teórica de las computadoras modernas. Aunque nunca se construyó en su época debido a limitaciones tecnológicas, su diseño incorporaba elementos que encontramos en las CPUs actuales, como una unidad de control para dirigir las operaciones, una unidad aritmética lógica para realizar cálculos y una memoria para almacenar datos e instrucciones. La visión de Babbage sentó las bases para el desarrollo de la computación programable.

A principios del siglo XX, aparecieron las primeras máquinas calculadoras electromecánicas, como las de IBM, que utilizaban tarjetas perforadas para la entrada de datos. Estas máquinas, aunque no eran programables en el sentido moderno, automatizaban tareas repetitivas y complejas, allanando el camino para la llegada de los primeros ordenadores electrónicos.

El desarrollo del transistor en 1947 marcó un punto de inflexión. Este pequeño dispositivo semiconductor reemplazó a las voluminosas y poco eficientes válvulas de vacío, permitiendo la miniaturización de los componentes electrónicos. Con la llegada del transistor, la construcción de ordenadores más compactos y potentes se convirtió en una realidad. Ejemplos de estos primeros ordenadores basados en transistores son el IBM 7090 y el DEC PDP-1. Estos sistemas, aunque todavía eran grandes y costosos, demostraron el potencial de la computación transistorizada y sentaron las bases para la creación de los primeros microprocesadores.

Hitos importantes en el desarrollo de las CPUs

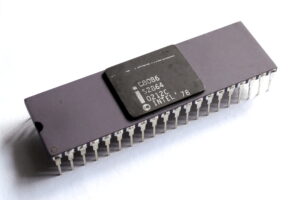

La década de 1970 trajo consigo la revolución del microprocesador. En 1971, Intel lanzó el Intel 4004, considerado el primer microprocesador comercial. Este chip, que integraba las funciones de una CPU en un único circuito integrado, abrió las puertas a la era de la computación personal. La miniaturización y la integración de los componentes permitieron la creación de ordenadores más pequeños, más asequibles y más accesibles para el público general.

A partir de este hito, la evolución de las CPUs ha sido vertiginosa. Intel y AMD se convirtieron en los principales fabricantes, impulsando la innovación con nuevas arquitecturas y mejoras constantes en el rendimiento. La arquitectura x86 de Intel, introducida en 1978 con el procesador Intel 8086, se convirtió en un estándar en la industria de la computación personal, y sigue siendo la base de la mayoría de los ordenadores de sobremesa y portátiles actuales.

Otros hitos importantes incluyen la introducción de la arquitectura de 64 bits, que permite a las CPUs gestionar una mayor cantidad de memoria y datos, la tecnología multinúcleo, que integra varios núcleos de procesamiento en un solo chip, multiplicando la capacidad de procesamiento, y la incorporación de instrucciones SIMD (Single Instruction, Multiple Data), que permiten a la CPU realizar la misma operación en varios datos simultáneamente, mejorando el rendimiento en tareas como el procesamiento de imágenes y vídeo.

Más recientemente, la integración de la Inteligencia Artificial (IA) en las CPUs ha abierto nuevas posibilidades. Procesadores con unidades dedicadas al procesamiento de IA, como las Neural Processing Units (NPUs), permiten la ejecución eficiente de algoritmos de aprendizaje automático, abriendo nuevas fronteras en campos como el reconocimiento de voz, la visión artificial y el análisis de datos.

La Ley de Moore y su impacto en la evolución de las CPUs

La Ley de Moore, formulada por Gordon Moore en 1965, ha sido la fuerza motriz detrás de la increíble evolución de las CPUs. Esta observación empírica predijo que el número de transistores en un circuito integrado se duplicaría aproximadamente cada dos años, lo que se traduciría en un aumento exponencial de la capacidad de procesamiento y una reducción del coste por transistor.

Durante décadas, la industria de la microelectrónica ha seguido la Ley de Moore, invirtiendo en investigación y desarrollo para miniaturizar los transistores y aumentar la densidad de los circuitos integrados. Esta ley ha permitido la creación de CPUs cada vez más potentes, eficientes y compactas, impulsando la revolución tecnológica que hemos presenciado en las últimas décadas.

Sin embargo, en los últimos años, la Ley de Moore se ha enfrentado a desafíos debido a las limitaciones físicas de la miniaturización. A medida que los transistores se acercan a la escala atómica, los efectos cuánticos comienzan a interferir en su funcionamiento, dificultando la continuación del ritmo de miniaturización previsto por Moore.

A pesar de estos desafíos, la industria continúa buscando nuevas formas de innovar para mantener el progreso. La investigación en nuevos materiales, como el grafeno, y nuevas arquitecturas, como la computación cuántica, prometen revolucionar la forma en que diseñamos y fabricamos las CPUs en el futuro. La búsqueda de una mayor eficiencia energética también se ha convertido en una prioridad, impulsando el desarrollo de CPUs de bajo consumo para dispositivos móviles e Internet de las Cosas (IoT).

La Ley de Moore ha sido un factor fundamental en la evolución de las CPUs, impulsando la innovación y la creación de dispositivos cada vez más potentes y versátiles. Aunque la miniaturización se enfrenta a limitaciones físicas, la búsqueda de nuevas tecnologías y arquitecturas promete un futuro emocionante para la evolución de la CPU.

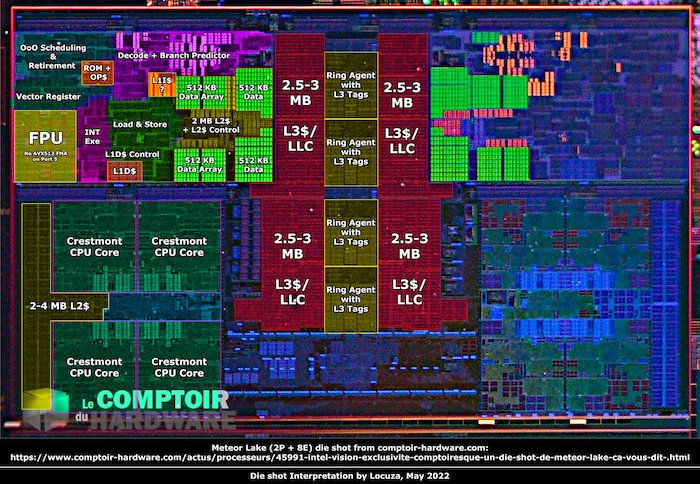

Anatomía de una CPU: Descifrando el Chip

Para comprender el funcionamiento de una CPU, es fundamental adentrarnos en su arquitectura y analizar sus componentes principales. En esta sección, exploraremos la anatomía de una CPU moderna, desgranando sus partes y funciones. Prepárate para un viaje microscópico al corazón del chip que impulsa la revolución digital.

Significado de CPU (Central Processing Unit)

Las siglas CPU corresponden a Central Processing Unit, que en español se traduce como Unidad Central de Procesamiento. Este nombre es bastante descriptivo, ya que la CPU es el núcleo central donde se procesan las instrucciones y se llevan a cabo las operaciones que hacen funcionar un ordenador. Es el “cerebro” del sistema, el director de orquesta que coordina y controla todas las demás partes.

Las funciones principales de la CPU son variadas y esenciales para el funcionamiento de un ordenador. Estas incluyen:

- Ejecutar instrucciones: La CPU interpreta y ejecuta las instrucciones de los programas, una tras otra. Estas instrucciones son secuencias de código que le indican a la CPU qué operaciones debe realizar.

- Realizar cálculos: La CPU es la encargada de realizar todo tipo de cálculos matemáticos, desde simples sumas y restas hasta complejas operaciones con números en coma flotante. Estos cálculos son esenciales para el funcionamiento de cualquier programa, desde un simple editor de texto hasta un complejo software de diseño 3D.

- Controlar el flujo de datos* La CPU controla el flujo de información entre la memoria, los dispositivos de entrada y salida, y otros componentes del sistema. Se asegura de que los datos se muevan de forma eficiente y correcta, permitiendo que los programas accedan a la información que necesitan en el momento adecuado.

- Gestionar la memoria: La CPU gestiona la memoria RAM del sistema, asignando y liberando espacio para los programas y los datos. Esto permite que los programas se ejecuten de forma eficiente, sin quedarse sin memoria y sin desperdiciar recursos.

Forma y componentes físicos: Un vistazo al chip

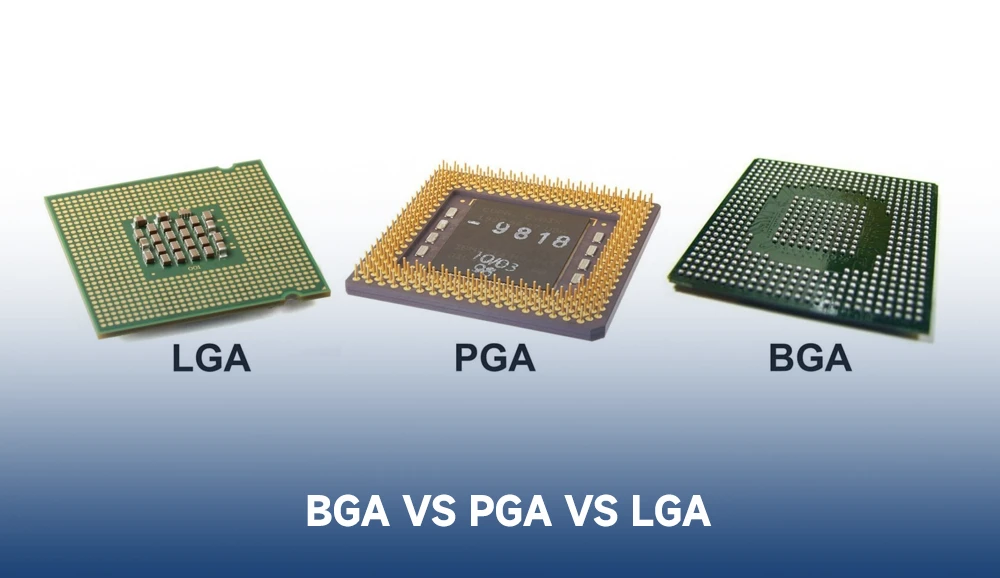

Físicamente, la CPU es un pequeño chip, generalmente cuadrado o rectangular, fabricado con silicio. Este chip se encuentra encapsulado en un material protector, que puede ser cerámico o plástico. La parte inferior del chip está cubierta de cientos o miles de pequeños contactos metálicos, llamados pines, que se utilizan para conectar la CPU a la placa base del ordenador. Estos pines permiten la comunicación entre la CPU y el resto de los componentes del sistema.

En la parte superior de la CPU, normalmente se encuentra un disipador de calor. Este componente, generalmente fabricado de metal, se utiliza para absorber y disipar el calor generado por la CPU durante su funcionamiento. El calor es un subproducto natural del proceso de computación, y si no se disipa adecuadamente, puede dañar la CPU. Para mejorar la eficiencia del disipador, se suele utilizar un ventilador o un sistema de refrigeración líquida, que ayuda a mover el aire caliente lejos de la CPU. En algunos casos, el disipador y el ventilador vienen integrados en un solo bloque, llamado cooler.

Componentes internos principales: El corazón del procesador

Dentro del chip de la CPU se encuentran diversos componentes, cada uno con una función específica. Estos componentes trabajan en conjunto para ejecutar las instrucciones y realizar las operaciones que hacen funcionar el ordenador. Algunos de los componentes más importantes son:

- Unidad de Control (CU): La Unidad de Control es el “director de orquesta” de la CPU. Se encarga de controlar el flujo de datos e instrucciones dentro del procesador. Interpreta las instrucciones de los programas y coordina las acciones de las demás unidades para que se ejecuten correctamente.

- Unidad Aritmético Lógica (ALU): La Unidad Aritmético Lógica es la “calculadora” del procesador. Realiza las operaciones aritméticas (suma, resta, multiplicación, división) y lógicas (comparaciones, operaciones booleanas) que son necesarias para ejecutar las instrucciones de los programas.

- Unidad de Coma Flotante (FPU): La Unidad de Coma Flotante es una unidad especializada en realizar cálculos con números en coma flotante. Estos números se utilizan para representar valores muy grandes o muy pequeños, y son esenciales para aplicaciones científicas, de ingeniería, y multimedia.

- Registros: Los registros son pequeñas unidades de memoria ultrarrápidas que se encuentran dentro de la CPU. Se utilizan para almacenar temporalmente datos e instrucciones que se están utilizando en ese momento. El acceso a los registros es mucho más rápido que el acceso a la memoria RAM, lo que acelera el procesamiento.

- Controlador de memoria: El controlador de memoria es el encargado de gestionar la comunicación entre la CPU y la memoria RAM del sistema. Se encarga de leer y escribir datos en la memoria, asegurando que la CPU tenga acceso a la información que necesita en el momento adecuado.

Estos componentes trabajan en conjunto, de forma coordinada y precisa, para que la CPU pueda ejecutar las instrucciones de los programas y realizar las tareas que le pedimos al ordenador. La complejidad de estos componentes y la forma en que interactúan entre sí es lo que permite que las CPUs modernas sean tan potentes y eficientes.

Características y especificaciones de las CPUs

Al elegir una CPU, es fundamental comprender las diferentes características y especificaciones que la definen. Estos parámetros son clave para determinar el rendimiento del procesador y su capacidad para ejecutar las tareas que le demandamos. En esta sección, desgranaremos las principales características y especificaciones de las CPUs, para que puedas entender qué significan y cómo influyen en su rendimiento.

Núcleos y Hilos

Un núcleo de CPU es una unidad de procesamiento independiente dentro del chip. Cada núcleo puede ejecutar instrucciones de forma simultánea, lo que permite al procesador realizar varias tareas al mismo tiempo. Una CPU con más núcleos puede manejar una mayor carga de trabajo y realizar multitarea de forma más eficiente.

Un hilo (o thread en inglés) es una secuencia de instrucciones que se ejecuta dentro de un núcleo. Un núcleo puede ejecutar varios hilos simultáneamente, lo que se conoce como multithreading. El Hyperthreading de Intel y el SMT (Simultaneous Multithreading) de AMD son tecnologías que permiten a un núcleo simular dos hilos lógicos, mejorando el rendimiento en aplicaciones que se benefician del multithreading.

Frecuencia de reloj

La frecuencia de reloj, medida en Hz (Hercios), y más comúnmente en GHz (Gigahercios) debido al aumento en las velocidades de procesamiento, indica la velocidad a la que la CPU puede ejecutar instrucciones. Cada ciclo de reloj representa una potencial instrucción procesada. Un procesador a 2 GHz, por ejemplo, puede teóricamente ejecutar 2 mil millones de instrucciones por segundo. Estas instrucciones pueden ser desde simples operaciones aritméticas como sumar dos números, hasta complejas operaciones de acceso a memoria o control de periféricos.

A mayor frecuencia de reloj, mayor es la velocidad de procesamiento, pero no es el único factor a considerar. La arquitectura de la CPU, la cantidad de caché y otros factores también juegan un papel importante. El récord actual de velocidad de una CPU es de 9.1 GHz, logrado mediante overclock extremo con nitrógeno líquido.

La frecuencia base es la velocidad mínima garantizada a la que funciona la CPU, mientras que la frecuencia turbo es la velocidad máxima que puede alcanzar el procesador bajo ciertas condiciones, como cuando se requiere un mayor rendimiento para tareas exigentes. El Hyperthreading permite a un solo núcleo físico simular dos núcleos lógicos, lo que permite procesar dos hilos de instrucciones simultáneamente. Esto mejora la eficiencia del procesador, especialmente en tareas que se pueden paralelizar. Sin embargo, no todos los programas se benefician del Hyperthreading.

En los últimos años, ha surgido la tendencia de diseñar CPUs con núcleos de diferente rendimiento. Algunos núcleos están optimizados para tareas de alto rendimiento, mientras que otros están diseñados para la eficiencia energética. Esta heterogeneidad permite un mejor equilibrio entre rendimiento y consumo energético.

Memoria Caché

La caché es una memoria de alta velocidad que se encuentra dentro de la CPU. Se utiliza para almacenar datos e instrucciones que se utilizan con frecuencia, lo que reduce el tiempo de acceso a la memoria RAM y acelera el procesamiento. La caché se divide en varios niveles: L1, L2 y L3.

La caché L1 es la más rápida y pequeña, con una latencia muy baja, generalmente de unos pocos ciclos de reloj. Se utiliza para almacenar los datos e instrucciones que se están utilizando en ese preciso momento. Debido a su velocidad y a la complejidad de su fabricación, la caché L1 es la más cara de implementar.

La caché L2 es más grande que la L1 y tiene una latencia ligeramente mayor. Se utiliza para almacenar datos e instrucciones que se han utilizado recientemente. Actúa como un intermediario entre la L1 y la L3.

La caché L3 es la más grande de las tres, pero también la más lenta. Se utiliza para almacenar datos e instrucciones que se han utilizado con menos frecuencia. La caché L3 es compartida entre todos los núcleos del procesador.

La cantidad y la velocidad de la caché son factores importantes a tener en cuenta al elegir una CPU, ya que pueden influir significativamente en el rendimiento, especialmente en aplicaciones que requieren un acceso rápido a los datos.

Arquitectura

La arquitectura de una CPU se refiere al diseño y la organización interna del procesador. Influye en la forma en que la CPU ejecuta las instrucciones, gestiona la memoria y se comunica con otros componentes del sistema. Dos de las arquitecturas más comunes son la x86 (o x86-64 para sistemas de 64 bits) y la ARM.

La arquitectura x86, desarrollada por Intel, ha sido la dominante en la industria de la computación personal durante décadas. Ha evolucionado desde sus inicios en la década de 1970 con el procesador Intel 8086, pasando por el 80286, el 80386 (que introdujo la arquitectura de 32 bits), el 80486, y luego la familia Pentium. Con la llegada del Pentium 4, se introdujo la arquitectura x86-64 (también conocida como AMD64), que extendió la arquitectura a 64 bits. Actualmente, la arquitectura x86-64 es el estándar en ordenadores de sobremesa y portátiles.

La diferencia entre una arquitectura de 32 bits y una de 64 bits radica principalmente en la cantidad de memoria RAM que puede direccionar el procesador. Una arquitectura de 32 bits está limitada a 4 GB de RAM, mientras que una arquitectura de 64 bits puede direccionar teóricamente hasta 16 exabytes (aunque en la práctica las limitaciones son menores). Esta capacidad de direccionar más memoria es esencial para las aplicaciones modernas, que a menudo requieren grandes cantidades de RAM para funcionar correctamente.

Actualmente, el estándar es la arquitectura de 64 bits, y la mayoría de los sistemas operativos y aplicaciones están diseñados para aprovecharla. Aunque se ha especulado sobre la posibilidad de arquitecturas de 128 bits, su desarrollo e implementación serían extremadamente complejos y no se consideran necesarios a corto plazo, ya que la arquitectura de 64 bits ofrece un espacio de direccionamiento de memoria suficiente para las necesidades actuales y futuras previsibles.

Proceso de fabricación

El proceso de fabricación se refiere a la tecnología utilizada para fabricar el chip de la CPU. Se mide en nanómetros (nm), que indican el tamaño de los transistores dentro del chip. Un proceso de fabricación más pequeño permite integrar más transistores en el mismo espacio, lo que se traduce en un mayor rendimiento y una mayor eficiencia energética.

La miniaturización de los transistores ha sido un factor clave en la evolución de las CPUs, permitiendo la creación de procesadores cada vez más potentes y eficientes, siguiendo la Ley de Moore. Empresas como TSMC (Taiwan Semiconductor Manufacturing Company) e Intel son líderes en la fabricación de chips, invirtiendo miles de millones de dólares en investigación y desarrollo para crear procesos de fabricación cada vez más avanzados.

Actualmente, los procesos de fabricación más avanzados se encuentran en el rango de los 5 nm e incluso menos. Estos procesos permiten integrar miles de millones de transistores en un solo chip, lo que se traduce en un aumento significativo del rendimiento y la eficiencia energética de las CPUs.

Socket y compatibilidad: Conexión con la placa base

El socket es el conector físico en la placa base donde se instala la CPU. El tipo de socket determina la compatibilidad entre la CPU y la placa base. Es esencial asegurarse de que la CPU que se elige sea compatible con el socket de la placa base.

Existen diferentes tipos de sockets, como el LGA (Land Grid Array), donde los pines de contacto se encuentran en la placa base, y el BGA (Ball Grid Array), donde los pines de contacto son pequeñas bolas de soldadura que se conectan a la placa base. El tipo de socket varía según el fabricante de la CPU y la generación del procesador. Por ejemplo, Intel utiliza el socket LGA para sus procesadores de escritorio, mientras que AMD utiliza el socket PGA (Pin Grid Array) para algunos de sus procesadores. Los procesadores para dispositivos móviles suelen utilizar el socket BGA, que permite una mayor miniaturización.

La compatibilidad entre la CPU y la placa base es fundamental para el correcto funcionamiento del sistema. Una CPU incompatible con la placa base no funcionará correctamente, o incluso podría dañar la placa base.

Consumo y voltaje

El TDP (Thermal Design Power) es una medida del consumo energético de la CPU. Se mide en vatios (W) e indica la cantidad de calor que genera el procesador durante su funcionamiento. Una CPU con un TDP más bajo consume menos energía y genera menos calor, lo que es importante para la eficiencia energética y la refrigeración del sistema.

El voltaje es la tensión eléctrica que se aplica a la CPU. Un voltaje más alto puede aumentar el rendimiento, pero también aumenta el consumo energético y la generación de calor. El voltaje se ajusta automáticamente por la placa base, pero también se puede modificar manualmente en algunos casos.

Bus del sistema

El bus del sistema es el canal de comunicación entre la CPU, la memoria RAM y otros componentes del sistema. Es como una autopista de datos que permite el intercambio de información entre los diferentes componentes. La velocidad del bus del sistema, medida en MHz (megahercios) o GT/s (gigatransfers por segundo), influye en la velocidad a la que se pueden transferir datos entre los componentes.

A lo largo de la historia, los buses del sistema han evolucionado para aumentar la velocidad y el ancho de banda de la comunicación entre los componentes del sistema.

En resumen, las características y especificaciones de las CPUs son factores clave para determinar su rendimiento y su capacidad para ejecutar las tareas que le demandamos. Comprender estos parámetros es fundamental para elegir la CPU adecuada para nuestras necesidades.

Funcionamiento de una CPU: El ciclo de vida de una instrucción

La CPU es una máquina compleja que realiza una serie de operaciones para ejecutar las instrucciones de un programa. Para comprender su funcionamiento a fondo, vamos a analizar el ciclo de vida de una instrucción y cómo la CPU interpreta el lenguaje binario.

Ciclo de instrucción

El ciclo de instrucción es el proceso fundamental que realiza la CPU para ejecutar una instrucción. Se divide en cuatro etapas principales:

-

Fetch (Búsqueda): En esta etapa, la CPU busca la siguiente instrucción a ejecutar. La dirección de memoria de la instrucción se encuentra en el Contador de Programa (PC), un registro especial que almacena la dirección de la próxima instrucción a ejecutar. La CPU accede a la memoria principal (RAM) en la dirección especificada por el PC y recupera la instrucción. La instrucción recuperada se almacena en el Registro de Instrucciones (IR) de la CPU.

-

Decode (Decodificación): Una vez que la instrucción está en el IR, la CPU la decodifica para entender qué operación debe realizar. El decodificador de instrucciones analiza el código de operación (opcode) de la instrucción, que indica el tipo de operación a realizar (suma, resta, salto, etc.). También identifica los operandos, que son los datos sobre los que se debe operar. Estos operandos pueden ser valores inmediatos, direcciones de memoria, o registros dentro de la CPU. El decodificador convierte la instrucción en una serie de señales de control que serán utilizadas en la siguiente etapa.

-

Execute (Ejecución): En esta etapa, la CPU ejecuta la operación decodificada en la etapa anterior. La Unidad Aritmético Lógica (ALU) se utiliza para realizar operaciones aritméticas y lógicas, como sumas, restas, comparaciones, etc. Para operaciones con números en coma flotante, se utiliza la Unidad de Coma Flotante (FPU). La CPU utiliza los operandos identificados en la etapa de decodificación y los procesa según el código de operación. El resultado de la operación se almacena en un registro dentro de la CPU.

-

Store (Almacenamiento): En esta última etapa, el resultado de la operación ejecutada se almacena en la memoria principal o en un registro, según lo especificado por la instrucción. Si la instrucción requiere almacenar el resultado en la memoria, la CPU escribe el valor en la dirección de memoria especificada. Si la instrucción requiere almacenar el resultado en un registro, el valor se transfiere al registro correspondiente.

Estas cuatro etapas forman el ciclo de instrucción básico. La CPU repite este ciclo continuamente, ejecutando millones o incluso miles de millones de instrucciones por segundo. La eficiencia de este ciclo es fundamental para el rendimiento del procesador.

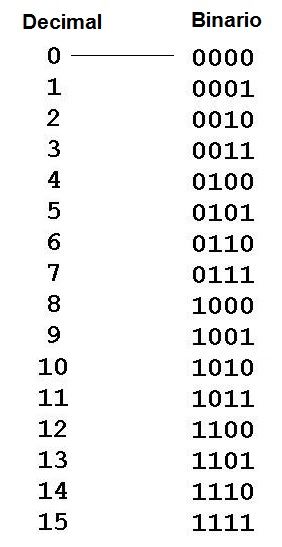

Interpretación del lenguaje binario: El lenguaje de las máquinas

La CPU “habla” en lenguaje binario, un sistema numérico que utiliza solo dos dígitos: 0 y 1. Estos dígitos, llamados bits, son la unidad fundamental de información en un ordenador. El lenguaje binario es esencial porque los circuitos electrónicos de la CPU solo pueden representar dos estados: encendido (1) o apagado (0).

Cada instrucción que ejecuta la CPU está codificada en una secuencia de bits. Esta secuencia representa el código de operación (opcode) y los operandos de la instrucción. El conjunto de instrucciones que una CPU puede entender se llama Set de Instrucciones (ISA) (Instruction Set Architecture).

El ISA es como el “diccionario” de la CPU. Define las instrucciones que la CPU puede ejecutar, el formato de las instrucciones, y la forma en que la CPU accede a la memoria y a los periféricos. Cada arquitectura de CPU tiene su propio ISA. Por ejemplo, la arquitectura x86 de Intel tiene un ISA diferente al de la arquitectura ARM.

Cuando la CPU lee una instrucción desde la memoria, la decodifica utilizando el ISA. El decodificador traduce la secuencia de bits en una serie de señales de control que activan los diferentes componentes de la CPU para ejecutar la operación especificada por la instrucción.

Por ejemplo, la instrucción “sumar el contenido del registro 1 al contenido del registro 2 y almacenar el resultado en el registro 1” podría estar representada en binario como “00000010 10000001 10000010”. Esta secuencia de bits se divide en diferentes campos, cada uno con un significado específico. El primer campo (00000010) podría representar el código de operación para la suma, mientras que los otros dos campos (10000001 y 10000010) podrían representar los registros 1 y 2, respectivamente.

La CPU utiliza el ISA para interpretar la secuencia de bits y determinar qué operación debe realizar. En este caso, la CPU activaría la ALU para realizar la suma y luego almacenaría el resultado en el registro 1, tal como lo indica la instrucción.

En resumen, la CPU es una máquina que interpreta y ejecuta instrucciones codificadas en lenguaje binario. El ciclo de instrucción y el set de instrucciones (ISA) son elementos fundamentales para el funcionamiento de la CPU. Comprender estos conceptos nos permite apreciar la complejidad y la precisión con la que la CPU realiza sus tareas.

Principales Fabricantes de CPUs

El mercado de las CPUs está dominado por un puñado de empresas que han liderado la innovación y el desarrollo de procesadores durante décadas. En esta sección, vamos a conocer a los principales fabricantes de CPUs, su historia y sus líneas de productos más destacadas.

Intel: El gigante azul

Fundada en 1968, Intel es sin duda el fabricante de CPUs más reconocido a nivel mundial. Su historia está llena de hitos, como la invención del primer microprocesador comercial de 4 bits, el Intel 4004, en 1971. Posteriormente, Intel desarrolló procesadores icónicos como el 8086, el 8088 (que se utilizó en el primer IBM PC), el 286, el 386 (que introdujo la arquitectura de 32 bits) y el 486. Estos procesadores sentaron las bases para la arquitectura x86, que ha dominado el mercado de las PCs durante décadas.

La arquitectura x86 se refiere a la serie de arquitecturas de conjuntos de instrucciones desarrolladas por Intel, comenzando con el 8086 en 1978. Esta arquitectura ha evolucionado a lo largo de los años, incluyendo extensiones como MMX, SSE y AVX, para mejorar el rendimiento en diferentes tipos de tareas.

Las líneas de productos principales de Intel incluyen:

- Intel Pentium Gold: Procesadores de gama media-baja, que ofrecen un rendimiento sólido para tareas cotidianas como navegar por internet, ofimática, multimedia y algunos juegos ligeros. Son una opción atractiva para usuarios que buscan un buen equilibrio entre precio y rendimiento.

- Intel Pentium: Procesadores de gama de entrada, ideales para usuarios con presupuestos ajustados que necesitan un procesador para tareas básicas como navegación web, ofimática y reproducción multimedia. Ofrecen un rendimiento suficiente para un uso cotidiano ligero.

- Intel Celeron: Procesadores de gama de entrada, enfocados en la eficiencia energética y el bajo coste. Son adecuados para tareas muy básicas como navegación web, ofimática y reproducción multimedia ligera. Son una opción popular para Chromebooks y otros dispositivos de bajo coste.

- Intel Core i3: Procesadores de gama de entrada, ideales para tareas básicas como navegar por internet, ofimática y multimedia.

- Intel Core i5: Procesadores de gama media, con un buen equilibrio entre rendimiento y precio, adecuados para juegos, edición de vídeo y otras tareas más exigentes.

- Intel Core i7: Procesadores de gama alta, con un alto rendimiento para usuarios avanzados, ideales para juegos de última generación, diseño gráfico, edición de vídeo profesional y multitarea intensiva.

- Intel Core i9: Procesadores de gama extrema, con el máximo rendimiento para entusiastas y profesionales, diseñados para las tareas más exigentes, como la renderización 3D, la edición de vídeo 8K y la simulación científica. Los Core i9 también están disponibles en versiones para estaciones de trabajo.

- Intel Xeon: Procesadores para servidores y estaciones de trabajo de alto rendimiento, diseñados para la virtualización, el análisis de datos y otras tareas empresariales.

Intel también fabrica procesadores para dispositivos móviles, como la familia Atom.

AMD: El rival rojo

AMD (Advanced Micro Devices) es el principal competidor de Intel en el mercado de las CPUs. Fundada en 1969, AMD ha sido un actor clave en la industria, impulsando la innovación y ofreciendo alternativas a los procesadores de Intel.

AMD ha lanzado procesadores icónicos a lo largo de su historia, como el K6, el Athlon y el Phenom. Sin embargo, fue con la arquitectura Zen, lanzada en 2017, que AMD logró un resurgimiento en el mercado. La arquitectura Zen ha tenido varias generaciones, mejorando el rendimiento con cada iteración.

Las líneas de productos principales de AMD incluyen:

- AMD Athlon: Procesadores de gama de entrada que ofrecen un rendimiento decente para tareas básicas como navegación web, ofimática, multimedia y juegos ligeros. Son una alternativa competitiva a los Intel Pentium y Celeron, especialmente para aquellos que buscan un buen rendimiento en juegos a un precio asequible.

- AMD Ryzen 3: Procesadores de gama de entrada, ideales para tareas básicas y juegos de nivel básico.

- AMD Ryzen 5: Procesadores de gama media, con un buen rendimiento para juegos y multitarea. Algunos modelos de Ryzen 5 incluyen gráficos integrados.

- AMD Ryzen 7: Procesadores de gama alta, con un alto rendimiento para juegos de última generación, edición de vídeo y multitarea intensiva. Algunos modelos de Ryzen 7 incluyen gráficos integrados.

- AMD Ryzen 9: Procesadores de gama extrema, con el máximo rendimiento para entusiastas y profesionales, diseñados para las tareas más exigentes.

- AMD EPYC: Procesadores para servidores y estaciones de trabajo, diseñados para la virtualización, el análisis de datos y otras tareas empresariales.

- AMD Ryzen Threadripper: Procesadores de gama extrema, con una gran cantidad de núcleos e hilos, diseñados para profesionales y entusiastas que necesitan el máximo rendimiento para tareas intensivas como la renderización 3D, la edición de vídeo profesional, la simulación científica y el desarrollo de software. Son una alternativa potente a los Intel Core i9 y Xeon para estaciones de trabajo.

AMD también fabrica procesadores para dispositivos móviles o videoconsolas.

Otros fabricantes: Más allá del duopolio

Aunque Intel y AMD dominan el mercado de las CPUs para ordenadores personales y servidores, existen otros fabricantes que desempeñan un papel importante en otros segmentos del mercado.

- ARM Holdings: ARM Holdings diseña arquitecturas de procesadores y las licencia a otros fabricantes, quienes luego las implementan y producen. La arquitectura ARM es la dominante en dispositivos móviles, como smartphones y tablets, debido a su bajo consumo energético y su alta eficiencia. ARM también ofrece diseños de referencia que los fabricantes pueden utilizar. Los chips Apple M están basados en una arquitectura ARM de 64 bits.

- IBM: IBM es un gigante de la tecnología que ha sido un actor clave en la historia de la computación. IBM fabrica procesadores para sus propios sistemas mainframe y servidores, como la familia POWER. La familia POWER se utiliza principalmente en servidores y sistemas empresariales, y es diferente de la arquitectura x86 utilizada en la mayoría de las PCs.

- Apple: Apple ha diseñado sus propios chips para sus dispositivos, como la serie M para Mac. Estos chips, basados en la arquitectura ARM de 64 bits, han logrado un gran rendimiento y una alta eficiencia energética. Apple ha diseñado estos chips para maximizar la integración con su software y hardware.

- VIA Technologies: VIA Technologies es un fabricante de CPUs, chipsets y otros componentes para ordenadores. Aunque no tan conocido como Intel o AMD, VIA ha tenido una presencia importante en el mercado de las CPUs de bajo consumo, especialmente para sistemas embebidos y mini-PCs.

Arquitecturas de una CPU

Las arquitecturas de CPU son los planos fundamentales que definen la estructura y el funcionamiento de un procesador. Cada arquitectura tiene sus propias características, ventajas y desventajas, y se elige según los requerimientos específicos de cada aplicación. En esta sección, exploraremos las dos arquitecturas más importantes en la actualidad: x86 y ARM, así como su impacto en el mercado y las tendencias emergentes.

x86 y x86-64: El legado de Intel y la era de los 64 bits

La arquitectura x86 fue desarrollada por Intel a finales de la década de 1970, comenzando con el procesador Intel 8086. Desde entonces, se ha convertido en la arquitectura dominante en el mercado de las PC de escritorio y portátiles. A lo largo de los años, x86 ha evolucionado con extensiones como MMX, SSE, y AVX para mejorar el rendimiento en diversas tareas, como multimedia y cálculo intensivo.

Con la introducción de la arquitectura x86-64 (también conocida como AMD64) por AMD a principios de la década de 2000, x86 se extendió a 64 bits. Esta ampliación permitió el direccionamiento de una mayor cantidad de memoria RAM y mejoró el rendimiento en aplicaciones que requieren grandes cantidades de recursos. La transición a 64 bits fue un hito crucial que permitió a las arquitecturas x86 manejar aplicaciones modernas y complejas, como videojuegos de alta definición y software de edición de vídeo.

Tendencias actuales:

- Optimización para Inteligencia Artificial (IA): Los procesadores x86 más recientes están siendo optimizados para manejar cargas de trabajo de IA. Esto incluye soporte para nuevas instrucciones y hardware especializado para acelerar el procesamiento de redes neuronales y aprendizaje automático.

- Seguridad mejorada: La arquitectura x86 sigue mejorando sus capacidades de seguridad para mitigar amenazas modernas. Las tecnologías como Intel Software Guard Extensions (SGX) y AMD Secure Encrypted Virtualization (SEV) proporcionan niveles adicionales de protección.

- Desarrollo de hardware especializado: Además de los núcleos de propósito general, los chips x86 ahora integran unidades dedicadas para tareas específicas, como gráficos y procesamiento de datos, mejorando así la eficiencia y el rendimiento en aplicaciones específicas.

Ventajas de la arquitectura x86:

- Amplia compatibilidad de software: La arquitectura x86 tiene una extensa historia y una gran cantidad de software disponible, incluyendo sistemas operativos y aplicaciones profesionales.

- Alto rendimiento en aplicaciones de un solo núcleo: Tradicionalmente, la arquitectura x86 ha mostrado un buen rendimiento en aplicaciones que no se benefician del multithreading debido a su robusta implementación de instrucciones de alto nivel.

- Gran ecosistema de hardware: Existe una amplia variedad de placas base, tarjetas gráficas y otros componentes compatibles con x86, lo que facilita la personalización y actualización de sistemas.

Desventajas de la arquitectura x86:

- Mayor consumo energético: Tradicionalmente, los procesadores x86 han tenido un mayor consumo energético que sus homólogos ARM, lo que los hace menos ideales para dispositivos móviles.

- Mayor complejidad: La arquitectura x86 es más compleja debido a su conjunto de instrucciones de propósito general (CISC), lo que puede dificultar su diseño y fabricación.

ARM: La eficiencia energética conquista el móvil y se expande a los PCs y Servidores

La arquitectura ARM (Advanced RISC Machine) fue desarrollada por ARM Holdings en la década de 1980. Se caracteriza por su bajo consumo energético y alta eficiencia, lo que la ha convertido en la arquitectura dominante en el mercado de dispositivos móviles, como smartphones y tablets.

En los últimos años, ARM ha comenzado a ganar terreno en el mercado de servidores, gracias a su eficiencia energética y escalabilidad. Empresas como Amazon, con su serie de procesadores Graviton, y Ampere Computing, están desarrollando procesadores ARM para servidores, ofreciendo alternativas a los procesadores x86 de Intel y AMD. Además, Apple ha optado por ARM para sus Mac, con la serie M de procesadores que destacan por su rendimiento y eficiencia.

Tendencias actuales:

- Expansión en el mercado de servidores: La arquitectura ARM está viendo un rápido crecimiento en centros de datos, gracias a su eficiencia energética y capacidad para manejar cargas de trabajo de nube y microservicios de manera eficiente.

- Desarrollo de IA y aprendizaje automático: ARM está integrando capacidades de IA directamente en sus chips, permitiendo que dispositivos móviles y servidores ejecuten modelos de aprendizaje automático de forma más eficiente.

- Soporte para computación heterogénea: ARM permite la integración fácil de GPUs y otros aceleradores en el mismo chip, optimizando así el procesamiento para aplicaciones que requieren computación paralela.

Ventajas de la arquitectura ARM:

- Bajo consumo energético: ARM es conocida por su bajo consumo energético, lo que la hace ideal para dispositivos móviles y servidores que buscan maximizar la eficiencia energética.

- Alta eficiencia: ARM es muy eficiente en el uso de recursos, permitiendo un alto rendimiento con un bajo consumo energético, especialmente en tareas paralelas.

- Escalabilidad: ARM es altamente escalable y se adapta a una amplia gama de dispositivos, desde microcontroladores pequeños hasta servidores de alto rendimiento.

Desventajas de la arquitectura ARM:

- Menor compatibilidad de software: Aunque la compatibilidad ha mejorado, ARM todavía tiene menos software disponible en comparación con x86, especialmente en aplicaciones de escritorio.

- Rendimiento en aplicaciones de un solo núcleo: Tradicionalmente, ARM ha tenido un menor rendimiento en aplicaciones de un solo núcleo en comparación con x86, aunque esta brecha ha disminuido con las mejoras en diseño y tecnología.

Comparativa x86 vs ARM: Dos gigantes con diferentes enfoques

La arquitectura x86 ha dominado el mercado de las PC de escritorio y portátiles durante décadas, gracias a su amplio ecosistema de software y hardware, y su alto rendimiento en aplicaciones de un solo núcleo. Sin embargo, ARM ha ganado terreno en los últimos años debido a su bajo consumo energético, alta eficiencia y escalabilidad.

Diferencias en diseño y enfoque:

- Conjunto de instrucciones (ISA): x86 utiliza un conjunto de instrucciones complejo (CISC), mientras que ARM utiliza un conjunto más simple (RISC), lo que afecta su eficiencia y rendimiento.

- Consumo energético: ARM está diseñada para bajo consumo energético, siendo ideal para dispositivos móviles y servidores de alta eficiencia, mientras que x86 tradicionalmente consume más energía.

- Escalabilidad: ARM es más escalable, adecuada para una variedad de dispositivos, desde pequeños a grandes. x86, aunque potente, es menos flexible para adaptarse a dispositivos más pequeños y de bajo consumo.

Pros y contras de cada arquitectura:

| Característica | x86 | ARM |

|---|---|---|

| Compatibilidad de software | Excelente | Buena |

| Rendimiento en un solo núcleo | Excelente | Bueno |

| Consumo energético | Alto | Bajo |

| Eficiencia | Buena | Excelente |

| Escalabilidad | Limitada | Excelente |

| Coste | Generalmente más alto | Generalmente más bajo |

Perspectivas futuras:

- Convergencia de arquitecturas: Con el avance de la tecnología, es posible que veamos una mayor convergencia entre las arquitecturas x86 y ARM. Algunas empresas ya están explorando diseños híbridos que combinan lo mejor de ambas arquitecturas para optimizar el rendimiento y la eficiencia.

- Desarrollo de tecnologías cuánticas: Aunque todavía en sus primeras etapas, la computación cuántica está emergiendo como una posible alternativa a las arquitecturas tradicionales, prometiendo resolver problemas complejos que son inabordables para las CPU actuales.

- Evolución de la computación en el borde: A medida que crece la demanda de procesamiento en tiempo real, especialmente en IoT y aplicaciones de automoción, ARM se encuentra bien posicionada para liderar la computación en el borde debido a su eficiencia y adaptabilidad.

Seguridad en CPUs

La seguridad de las CPUs es esencial para garantizar la integridad y confidencialidad de los datos en un mundo cada vez más digital. Las vulnerabilidades en los procesadores pueden tener graves consecuencias, ya que estos componentes son el corazón de cualquier sistema informático. En esta sección, exploraremos algunas de las vulnerabilidades más conocidas en CPUs y las tecnologías de seguridad integradas que están diseñadas para proteger datos sensibles y mitigar amenazas potenciales.

Vulnerabilidades conocidas: Cuando el corazón del sistema se tambalea

A lo largo de los años, se han descubierto varias vulnerabilidades críticas en CPUs que pueden ser explotadas por atacantes para acceder a información confidencial o tomar control del sistema. Estas vulnerabilidades subrayan la importancia de la seguridad en el diseño de procesadores. A continuación, se describen algunas de las más significativas de los últimos años:

- Meltdown y Spectre (2018): Estas vulnerabilidades sacudieron el mundo de la informática al demostrar cómo la ejecución especulativa, una técnica de optimización de rendimiento utilizada por los procesadores modernos, podría ser explotada para acceder a información sensible.

- Meltdown: Afecta principalmente a los procesadores Intel y permite a los atacantes leer toda la memoria de un sistema, incluyendo datos sensibles. Meltdown rompe el aislamiento entre las aplicaciones de usuario y el sistema operativo.

- Spectre: Afecta a una gama más amplia de procesadores, incluyendo Intel, AMD y ARM. Spectre engaña a los programas para que accedan a ubicaciones de memoria arbitrarias, permitiendo a los atacantes leer el contenido de dichas ubicaciones. Spectre es particularmente insidioso porque requiere cambios a nivel de software para mitigarse eficazmente.

- Foreshadow (2018): También conocida como L1 Terminal Fault (L1TF), esta vulnerabilidad es una variante de Spectre que ataca específicamente la tecnología de enclaves seguros Intel SGX (Software Guard Extensions). Permite a los atacantes extraer información sensible de estos enclaves, que están diseñados para proteger datos altamente confidenciales.

- ZombieLoad (2019): Esta vulnerabilidad explota una característica de los procesadores Intel llamada Microarchitectural Data Sampling (MDS). ZombieLoad permite a los atacantes leer datos que están siendo procesados por el CPU, incluyendo información sensible que debería estar protegida. Este ataque es particularmente preocupante porque puede extraer datos de diferentes procesos, violando el aislamiento de la memoria.

Impacto de las vulnerabilidades

Estas vulnerabilidades tienen implicaciones significativas para la seguridad de los usuarios. Un atacante que explote estas fallas podría robar información confidencial, como contraseñas, claves de cifrado y datos financieros, poniendo en riesgo la privacidad y seguridad de los individuos y organizaciones. Además, debido a la naturaleza generalizada de estas vulnerabilidades, su mitigación a menudo requiere actualizaciones de microcódigo, parches de software y cambios en el diseño de hardware, lo que puede afectar al rendimiento del sistema.

Tecnologías de seguridad integradas

Para mitigar las vulnerabilidades y fortalecer la seguridad de las CPUs, los fabricantes han desarrollado una serie de tecnologías de seguridad integradas. Estas innovaciones están diseñadas para proteger los datos sensibles y proporcionar un entorno seguro para la ejecución de aplicaciones críticas. Algunas de las tecnologías más importantes incluyen:

- Intel SGX (Software Guard Extensions): Esta tecnología permite a los desarrolladores crear enclaves seguros dentro de la memoria del procesador, protegiendo los datos sensibles contra accesos no autorizados, incluso del sistema operativo o software malicioso. Intel SGX es particularmente útil en aplicaciones donde la privacidad de los datos es crucial, como en servicios financieros y de salud.

- AMD SEV (Secure Encrypted Virtualization): AMD SEV permite la encriptación de la memoria de las máquinas virtuales (VMs), protegiendo los datos de las VMs contra accesos no autorizados, incluso del hipervisor. Esta tecnología es fundamental para la seguridad en entornos virtualizados y de nube, donde múltiples máquinas virtuales pueden ejecutarse en el mismo hardware físico.

- ARM TrustZone: TrustZone divide el procesador en dos entornos de ejecución: un entorno seguro para ejecutar código y almacenar datos sensibles, y un entorno normal para tareas no críticas. Esta partición ayuda a proteger aplicaciones críticas, como la gestión de claves y la autenticación, asegurando que las operaciones sensibles se realicen en un entorno aislado y seguro.

Aplicaciones prácticas y futuras estrategias

Estas tecnologías de enclave seguro son fundamentales para la protección de datos sensibles en entornos virtualizados y en la nube. Permiten a los usuarios ejecutar aplicaciones y almacenar datos sensibles en un entorno seguro, protegiéndolos de accesos no autorizados, incluso del proveedor de servicios en la nube.

Además, los fabricantes de CPUs están explorando nuevas estrategias para mejorar la seguridad, tales como:

- Aislamiento a nivel de hardware: Desarrollar técnicas más avanzadas para aislar procesos y minimizar las posibilidades de que las vulnerabilidades afecten a múltiples aplicaciones simultáneamente.

- Desarrollo de sistemas inmunes a fallas: Implementar arquitecturas redundantes que puedan detectar y corregir automáticamente fallos de seguridad, asegurando la continuidad de las operaciones críticas.

- Colaboración con la comunidad de seguridad: Trabajar más estrechamente con investigadores de seguridad para identificar proactivamente vulnerabilidades y desarrollar mitigaciones efectivas antes de que puedan ser explotadas en el mundo real.

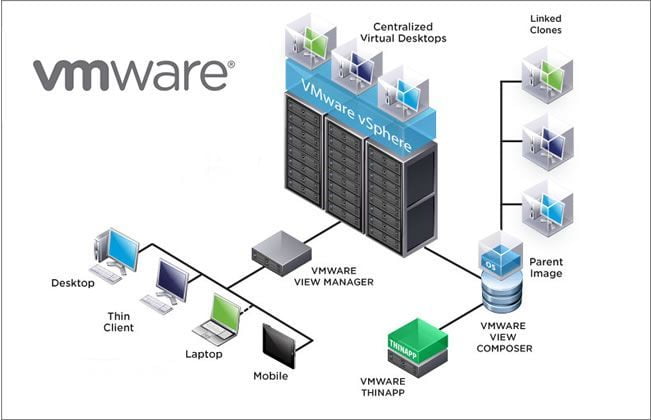

Virtualización y CPUs

La virtualización es una tecnología que permite crear múltiples entornos virtuales en un solo sistema físico. Estos entornos virtuales, llamados máquinas virtuales (VMs), actúan como si fueran ordenadores independientes, cada uno con su propio sistema operativo y aplicaciones. En esta sección, exploraremos qué es la virtualización y el papel crucial que desempeñan las CPUs en este proceso.

¿Qué es la virtualización?

La virtualización permite aprovechar al máximo los recursos de un sistema físico, dividiéndolos entre varias máquinas virtuales. Esto permite ejecutar múltiples sistemas operativos y aplicaciones en un solo servidor, lo que reduce los costes de hardware, energía y espacio.

Existen diferentes tipos de virtualización, como la virtualización de servidores, la virtualización de escritorios y la virtualización de aplicaciones. Cada tipo de virtualización tiene sus propias ventajas y se utiliza en diferentes escenarios.

El papel de la CPU en la virtualización

La CPU es el componente clave que hace posible la virtualización. La CPU se encarga de ejecutar las instrucciones de las diferentes máquinas virtuales, creando la ilusión de que cada máquina virtual tiene su propio procesador dedicado.

Las CPUs modernas incluyen características de virtualización por hardware, como Intel VT-x y AMD-V, que mejoran el rendimiento y la seguridad de la virtualización. Estas características permiten a la CPU gestionar de forma eficiente la ejecución de las máquinas virtuales, mejorando la eficiencia y la seguridad del sistema.

La virtualización ha revolucionado la forma en que se utilizan los recursos informáticos, permitiendo una mayor flexibilidad, eficiencia y escalabilidad. Las CPUs desempeñan un papel fundamental en la virtualización, haciendo posible la creación de múltiples entornos virtuales en un solo sistema físico.

Para profundizar en el tema de la virtualización, te recomendamos leer los siguientes artículos de nuestra web:

Overclocking de CPUs: Exprimiendo al máximo el rendimiento

El overclocking es una técnica que permite aumentar la frecuencia de reloj de una CPU por encima de las especificaciones del fabricante. Esto puede mejorar el rendimiento del procesador, pero también conlleva algunos riesgos. En esta sección, exploraremos qué es el overclocking, sus ventajas y riesgos, y los métodos básicos para realizarlo.

¿Qué es el Overclocking?:

El overclocking consiste en aumentar la frecuencia de reloj de la CPU, es decir, la velocidad a la que el procesador ejecuta las instrucciones. Esto se puede lograr modificando la configuración del BIOS de la placa base o utilizando software especializado.

Al aumentar la frecuencia de reloj, se aumenta el número de instrucciones que la CPU puede ejecutar por segundo, lo que se traduce en un mayor rendimiento en juegos, aplicaciones y otras tareas que requieren un alto rendimiento del procesador.

Ventajas y riesgos del Overclocking

Ventajas del Overclocking:

Mayor rendimiento: El overclocking puede mejorar significativamente el rendimiento del procesador, especialmente en juegos y aplicaciones exigentes.

Mayor vida útil del procesador: En algunos casos, el overclocking puede prolongar la vida útil del procesador, ya que permite compensar la pérdida de rendimiento que se produce con el tiempo.

Ahorro de costes: El overclocking puede permitir a los usuarios obtener un mayor rendimiento sin tener que comprar un procesador nuevo.

Riesgos del Overclocking:

Inestabilidad del sistema: El overclocking puede hacer que el sistema se vuelva inestable, provocando errores, bloqueos e incluso daños en el hardware.

Sobrecalentamiento: El overclocking aumenta la temperatura del procesador, lo que puede provocar sobrecalentamiento y daños en el hardware si no se dispone de una refrigeración adecuada.

Reducción de la vida útil del procesador: En algunos casos, el overclocking puede reducir la vida útil del procesador, especialmente si se realiza de forma incorrecta.

Métodos básicos de Overclocking: Ajustes precisos para un rendimiento óptimo

Existen diferentes métodos para realizar overclocking, pero los más comunes son:

Modificación del BIOS: La mayoría de las placas base permiten modificar la configuración del BIOS para ajustar la frecuencia de reloj, el voltaje y otros parámetros del procesador.

Software especializado: Existen programas especializados que permiten realizar overclocking de forma más sencilla e intuitiva.

Antes de realizar overclocking, es importante investigar y comprender los riesgos involucrados. También es recomendable utilizar herramientas de monitoreo para controlar la temperatura y la estabilidad del sistema durante el proceso.